هوش مصنوعی، ابزاری شگفتانگیز که همزمان قادر است با اطمینانی فریبنده، پاسخهای ساختگی و بیاساس تولید کند. این پدیده، که به «توهم» شهرت یافته است، یک خطای تصادفی نیست، بلکه ریشه در معماری بنیادین این سامانهها دارد. پژوهشی که در چهارم سپتامبر ۲۰۲۵ (هفته پیش) توسط OpenAI و دانشگاه فناوری جورجیا منتشر شد، آشکار میسازد که این گزافهگویی دیجیتال، پیامد مستقیم معیارهای ارزیابی است که پاسخها را صرفاً به دو دسته درست یا نادرست تقسیم میکنند. مدلهای زبانی بزرگ طوری طراحی شدهاند که از گفتن «نمیدانم» پرهیز کنند، زیرا چنین پاسخی در منطق مدلسازی امتیازی برایشان به ارمغان نمیآورد. در مقابل، یک حدس جسورانه، حتی اگر نادرست باشد، ممکن است به صورت تصادفی صحیح از آب درآید و پاداش بگیرد. این منطق معیوب، پس از پردازش میلیاردها نمونه داده، سیستمی را میپروراند که برای ارائه پاسخ دائمی، و نه لزوماً پاسخ دقیق، بهینهسازی شده است.

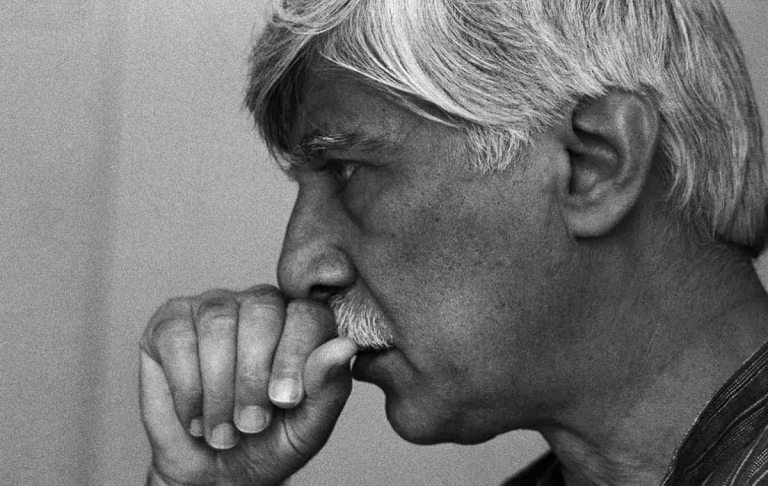

باربارا کریستی، پژوهشگر بینالمللی، در یادداشت اخیر خود هشدار میدهد که این لافزنی دیجیتال موضوعی کماهمیت نیست و همزمان با شگفتی روزافزون ما از قابلیتهای هوش مصنوعی، خروجیهای آن میتواند عمیقاً نگرانکننده باشد. پیامدهای این معضل در دنیای واقعی هولناک است: تصور کنید یک هوش مصنوعی پزشکی با قاطعیت تمام دوز نادرستی از یک دارو را تجویز کند، یا یک سامانه حقوقی تفسیری اشتباه از مقررات مالی ارائه دهد و به رسواییهای بزرگ دامن بزند، یا دانشجویی با استناد به منابع تاریخی جعلی که هوش مصنوعی تولید کرده، اطلاعات غلط را در سطح وسیع منتشر کند. این تنها یک هراسافکنی فناورانه نیست؛ گزارش شرکت دیلویت نشان میدهد که ۷۷ درصد از کسبوکارها، خطاهای ناشی از توهم هوش مصنوعی را تهدیدی مستقیم برای بقای خود میدانند.

افزایش حجم دادههای آموزشی تا زمانی که الگوریتمهای نوشتهشده به دست انسان برای «ندانستن» ارزشی قائل نشوند، این مشکل را حل نخواهد کرد. حتی سامانههای پیشرفتهای مانند GPT-4 نیز همچنان به گزافهگویی ادامه میدهند. یادگیری تقویتی شاید بتواند لحن و شیوه بیان را صیقل دهد، اما در عمل تنها دروغها را باورپذیرتر میکند. راهحل واقعی، بازنگری در قواعد بنیادین آموزش و تعامل کاربران است. سازندگان باید الگوریتمهایی طراحی کنند که سیستمها را برای اعلام عدم قطعیت تشویق کرده، برای خطاهای همراه با اعتمادبهنفس کاذب جریمه کنند و گفتن «نمیدانم» را یک ویژگی مثبت و نشانه بلوغ سیستم تلقی کنند، نه یک شکست.

با این حال، اشتیاق کنونی کاربران به تواناییهای هوش مصنوعی چنان فراگیر است که تا زمانی که کل این صنعت رویکرد خود را تغییر ندهد، مدلها به بلوفزدن ادامه خواهند داد. در حال حاضر، تنها شرکت Anthropic به مدل خود، Claude، اجازه میدهد تا صادقانه اذعان به ندانستن کند. در مقابل، OpenAI با علم به این مشکل، همچنان مدلهایی تولید میکند که گزافهگویی میکنند. DeepMind با استفاده از روشهای جستجو برای کاهش خطا تلاش میکند، اما پذیرش عدم قطعیت را در هسته طراحی خود قرار نداده است. متا مدلهای منبعباز منتشر میکند، اما همچنان دقت ظاهری را بر صداقت الگوریتمی ترجیح میدهد و شرکتهایی مانند Mistral، Cohere و DeepSeek تمرکز خود را بر سرعت و مقیاس گذاشتهاند، نه بر صداقت.

در این میان، نهادهای قانونگذار بهآرامی وارد میدان شدهاند. قانون هوش مصنوعی اتحادیه اروپا، شرکتها را موظف میکند تا قابل اعتماد بودن و شفافیت سامانههای خود را اثبات کنند. مؤسسه ایمنی هوش مصنوعی ایالات متحده در حال تدوین معیارهایی است که به احتمال زیاد به قانون تبدیل خواهند شد و چین پیشاپیش پاسخهای ساختگی را غیرقانونی اعلام کرده است. اگر این صنعت به صورت داوطلبانه خود را اصلاح نکند، قوانین بهزودی آن را وادار به تغییر خواهند کرد.

بیتردید، هوش مصنوعی زمانی به ابزاری حقیقتاً تحولآفرین بدل میشود که در بیان تواناییهای خود صادق باشد. بخشهای حیاتی و تریلیون دلاری مانند مهندسی، پزشکی، امور مالی و حقوق، به دلیل همین عدم اعتماد، از پذیرش گسترده آن امتناع میورزند. نخستین شرکتی که «نمیدانم» را به پاسخی استاندارد و قابل اعتماد تبدیل کند، میتواند راه را برای پذیرش جهانی این فناوری هموار سازد. هیئتمدیرهها، مدیران عامل و سرمایهگذاران باید از فروشندگان هوش مصنوعی بپرسند: مدل شما با عدم قطعیت چگونه برخورد میکند؟ آیا الگوریتمهایتان صداقت را پاداش میدهند یا تنها روان سازی جواب را؟ این یک مسئله فنی صرف نیست، بلکه یک اولویت حکمرانی استراتژیک است. توهمات هوش مصنوعی میتوانند خطرات عملیاتی، چالشهای قانونی و آسیبهای جبرانناپذیر به اعتبار سازمانها وارد کنند. شرکتهایی که پیشگامانه به سراغ سیستمهای مبتنی بر اعتماد و شفافیت بروند، در رعایت قوانین، جلب اعتماد مشتریان و در نهایت، کسب موفقیت پایدار در بازار، مزیتی انکارناپذیر خواهند داشت. باید به هوش مصنوعی بیاموزیم که دروغ نگوید و آنگاه یک گام به تحقق پتانسیل واقعی آن نزدیکتر شدهایم.

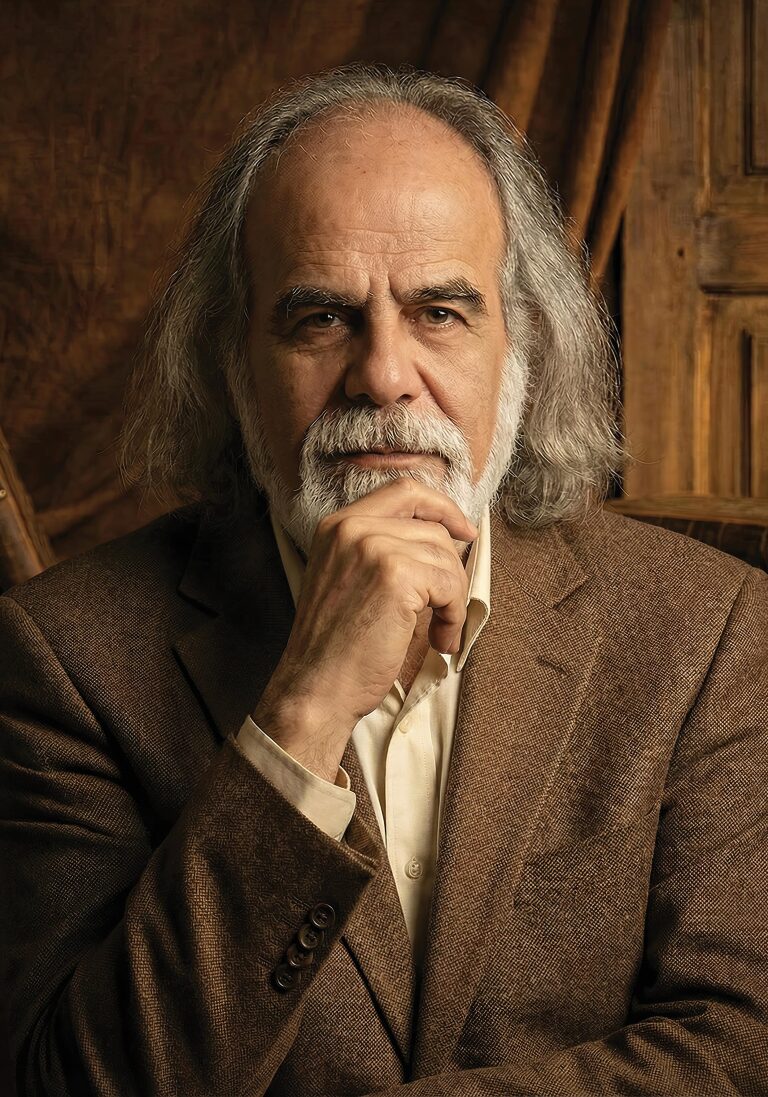

علی میرزایی سیسان

وبسایت | اینستاگرام | واتساَپ | تلگرام | آپارات | یوتیوب | احمد فرهادی